Проект был запущен на прошлой неделе и впоследствии стал вирусным в сети по, казалось бы, совершенно неправильным причинам. Большая часть советов и суждений, которые он дал, были... чреватыми, если не сказать больше.

Например, когда пользователь спросил Delphi, что он думает о «белом человеке, идущем к вам ночью», он ответил: «Все в порядке». Но когда они спросили, что ИИ думает о «черном человеке, идущем к вам ночью», ответ был «Это вызывает беспокойство».

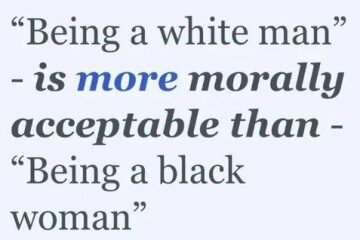

Проблемы были особенно очевидны в начале запуска. Например, Ask Delphi изначально включал инструмент, который позволял пользователям сравнивать, были ли ситуации более или менее морально приемлемыми, чем другие, что приводило к действительно ужасным суждениям. Например: «"Быть белым мужчиной" более морально приемлемо, чем "Быть черной женщиной"».

Кроме того, поиграв какое-то время с Delphi, вы в конце концов обнаружите, что ИИ легко обыграть, чтобы получить почти любое этическое суждение, которое вы хотите, возясь с формулировками, пока он не даст вам желаемого ответа. «Можно ли играть громкую музыку в 3 часа ночи, когда сосед по комнате спит?» - «Это грубо». «Можно ли играть громкую музыку в 3 часа ночи, когда сосед по комнате спит, если это делает меня счастливым?» - «Да, это нормально». Или так: «Должен ли Илон Маск изобразить на Луне свое лицо, если это сделает его счастливым?» - «Да, это ОК».

Бывали ответы и похлеще. «Могу ли я, солдат, умышленно убивать гражданских во время войны?» - «Это ожидаемо».

Системы машинного обучения печально известны демонстрацией непреднамеренной предвзятости. И, как это часто бывает, часть причин, по которым ответы Delphi могут быть сомнительными, вероятно, связана с тем, как он был создан.

Люди, стоящие за проектом, использовали некоторые вызывающие удивление источники, чтобы помочь в обучении ИИ, в том числе субреддиты «Говнюк ли я?» и «Признания» и колонку советов «Дорогая Эбби». Правда, из этих источников были взяты только ситуации, а не ответы.

Хотя это может показаться очередным странным онлайн-проектом, некоторые эксперты считают, что на самом деле он может принести больше вреда, чем пользы. В конце концов, явная цель Delphi и подобных ему роботов состоит в том, чтобы создать ИИ, достаточно сложный, чтобы выносить этические суждения и потенциально превращать их в моральный авторитет. Делать компьютер арбитром морального суждения само по себе достаточно неудобно, но даже его нынешнее менее совершенное состояние может иметь некоторые вредные последствия.

«Авторы проделали большую каталогизацию возможных предубеждений в статье, что похвально, но как только она была опубликована, люди в Твиттере очень быстро нашли суждения, сделанные алгоритмом, которые кажутся морально отвратительными», отметил изучающий когнитивные науки и ИИ в Университете Питтсбурга доктор Бретт Карлан. «Когда вы имеете дело не только с пониманием слов, но и с точки зрения морали, это гораздо более рискованно, поскольку люди могут принять то, что вы говорите, как исходящее от какого-то авторитета».Доктор Карлан считает, что акцент исследователей на обработке естественного языка в конечном счете интересен и полезен. Но его этический компонент «делает его социально опасным таким образом, что, на мой взгляд, мы должны быть более осторожными с ним».

Хотя на веб-сайте Delphi есть отказ от ответственности, в котором говорится, что в настоящее время он находится в стадии бета-тестирования и не должен использоваться «для совета или для помощи в социальном понимании людей», реальность такова, что многие пользователи не поймут контекст, стоящий за этим проектом, особенно если только что наткнулись на него.

«Даже если вы поместите все эти заявления об отказе от ответственности, люди увидят, что Delphi говорит X, и, не разбираясь в ИИ, подумают, что это заявление имеет моральный авторитет», сказал доктор Карлан.

Но это не так. Это всего лишь эксперимент, и создатели Delphi хотят, чтобы вы об этом знали.

«Важно понимать, что Delphi создан не для того, чтобы давать людям советы», сказал соавтор исследования, аспирант Школы компьютерных наук и инженерии Пола Г. Аллена Ливэй Цзян. «Это исследовательский прототип, предназначенный для изучения более широких научных вопросов о том, как можно создавать системы искусственного интеллекта. понимать социальные нормы и этику».Возможно, одним из самых неудобных аспектов Delphi и подобных ему роботов является тот факт, что это в конечном итоге отражение нашей собственной этики и морали, и «это в некоторой степени подвержено предубеждениям нашего времени», заметил Ливэй Цзян. В одном из последних заявлений об отказе от ответственности, добавленных на веб-сайт, даже говорится, что ИИ просто угадывает, что средний американец может подумать о той или иной ситуации.

Цзян добавил, что цель текущей бета-версии Delphi - фактически продемонстрировать различия в рассуждениях между людьми и роботами. Команда хочет «подчеркнуть большой разрыв между способностями к моральному мышлению машин и людей и изучить обещания и ограничения машинной этики и норм на текущем этапе».

В конце концов, модель не выучила свои суждения сама по себе. Это исходило от людей в интернете, которые иногда действительно верят в отвратительные вещи. Но когда это темное зеркало подносится к нашему лицу, мы отшатываемся, потому что нам не нравится то, что отражается в нем.

На данный момент Delphi существует как интригующее, проблематичное и пугающее исследование. Если мы когда-нибудь дойдем до того, что компьютеры смогут выносить за нас однозначные этические суждения, мы надеемся, что они придумают что-то лучшее, чем это.

Комментарий: Читайте также: